Новые модели Llama 3.2 представлены в облегчённом и визуальном вариантах. Визуальные модели хорошо справляются с обработкой изображений. Они используют изображения и подсказки для генерации ответа, в то время как облегчённые модели хорошо справляются с генерацией многоязычного текста и вызовом инструментов в сложных случаях.

В этом руководстве мы узнаем, как получить доступ к моделям Lightweight и Vision Llama 3.2 с помощью приложения Msty. Msty — это бесплатное настольное приложение-чатбот с множеством функций. Вы можете скачать и использовать модель с открытым исходным кодом или подключиться к онлайн-модели с помощью ключа API.

Загрузка Msty и модели Llama 3.2

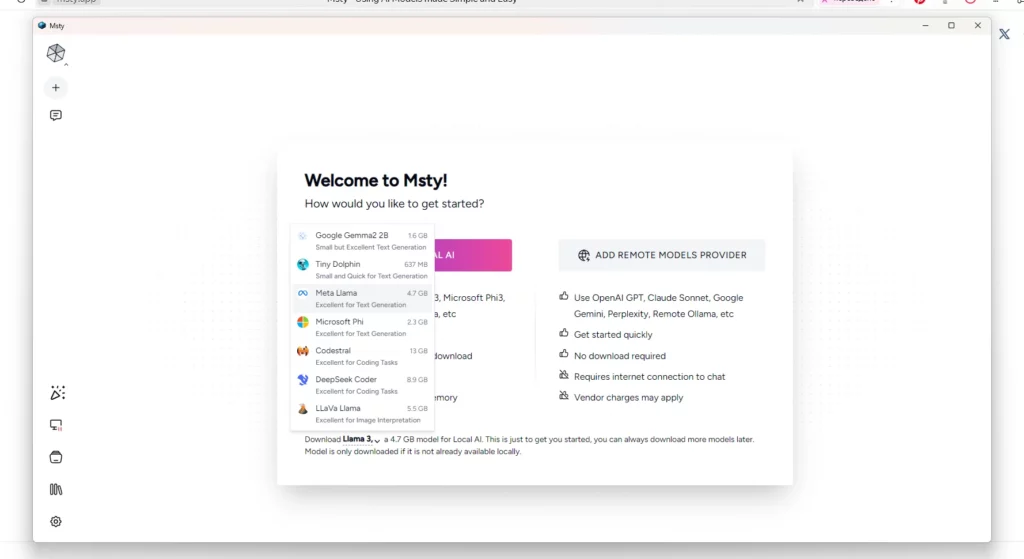

Чтобы использовать модели Llama 3.2 локально на вашем ноутбуке, сначала нужно скачать и установить Msty. Затем мы загрузим модель Llama 3.2.

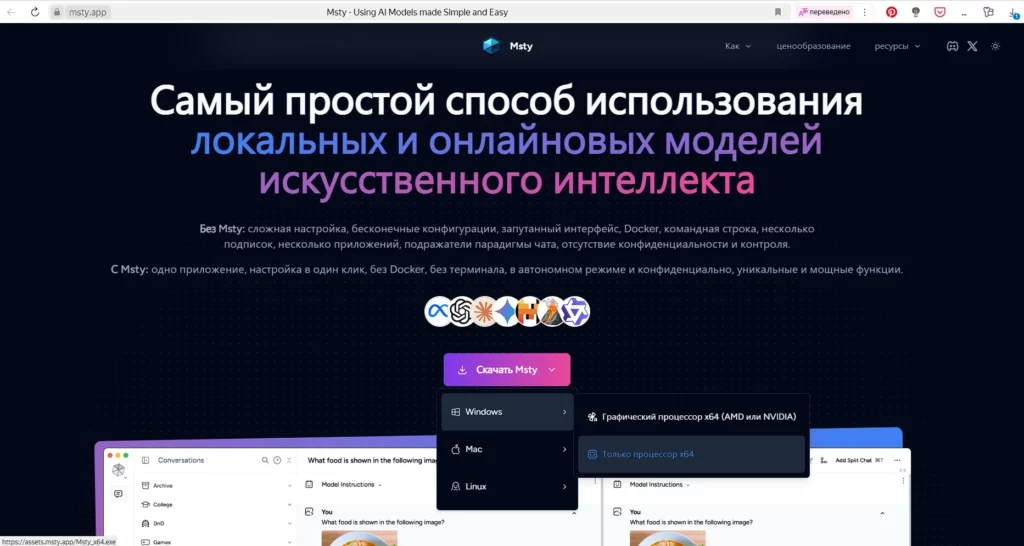

- Перейдите на сайт msty.app и скачайте приложение Msty.

- Установите его с параметрами по умолчанию.

Скриншот из Msty.app – для своего ноутбука я выбрал CPU x64

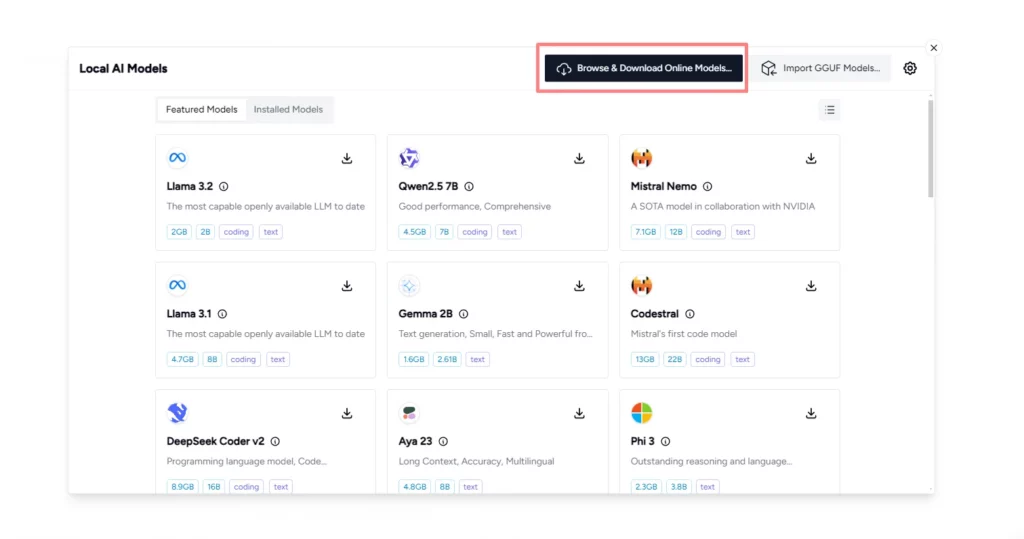

- Нажмите на кнопку шестеренки «Settings» в левом нижнем углу, выберите вкладку «Local AI», нажмите на кнопку «Manage Local AI Models» (Управление локальными моделями ИИ – верху справа), а затем нажмите на «Browse & Download Online Models» (Просмотр и загрузку онлайн-моделей).

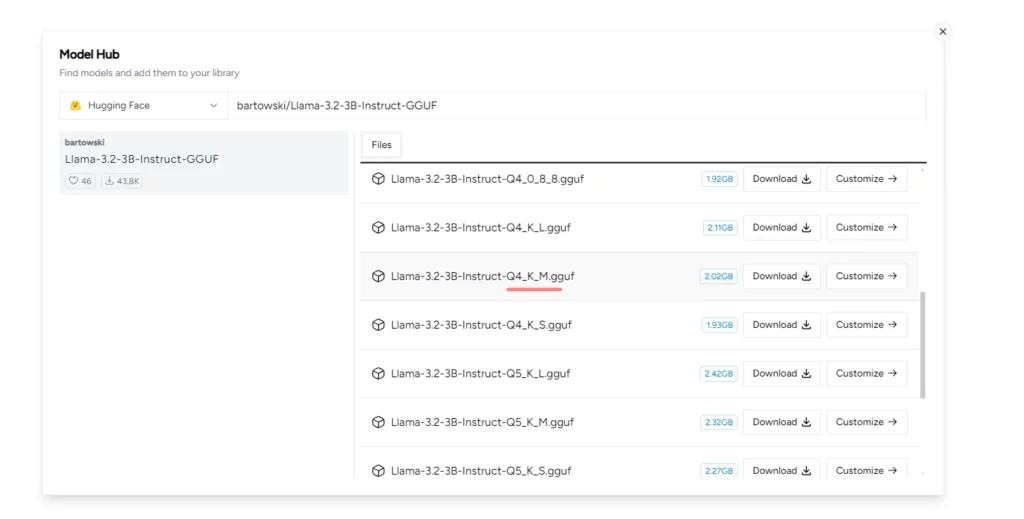

- Измените вкладку поставщика моделей на “Hugging Face” и введите следующую ссылку на репозиторий моделей: “bartowski/Llama-3.2-3B-Instruct-GGUF”.

- Выберите версию файла модели “Q4_k_M.gguf” и нажмите на кнопку загрузки. Загрузка полной модели займет несколько минут.

Локальное использование Llama 3.2 3B Instruct

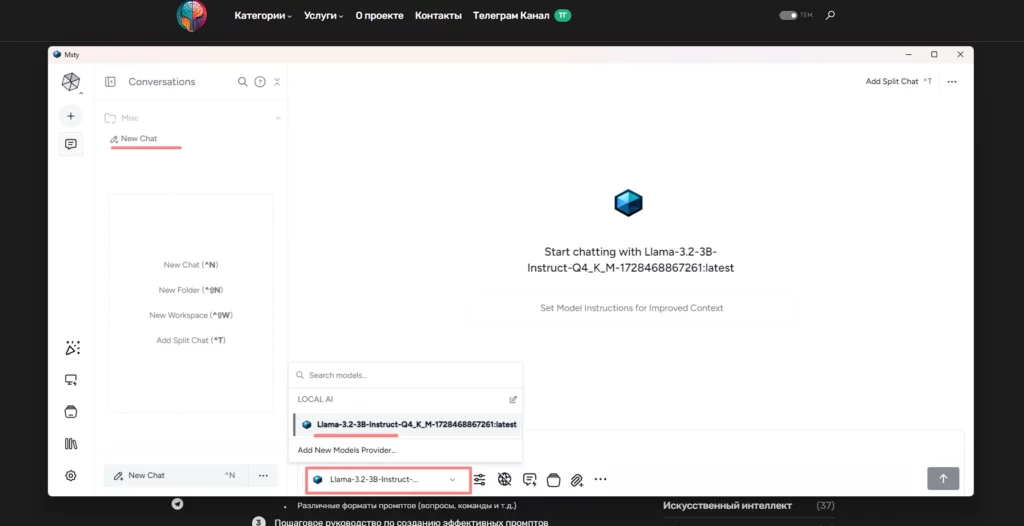

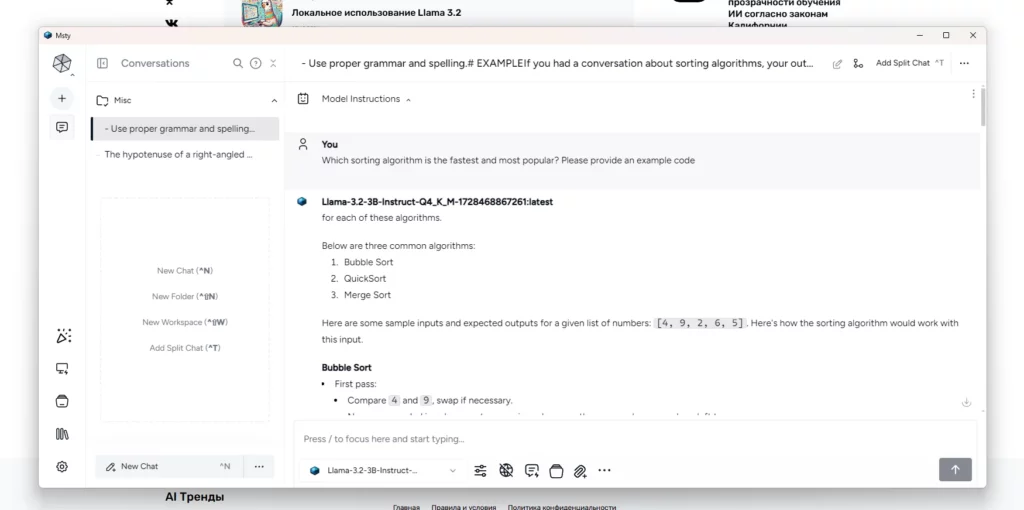

После завершения загрузки мы перейдём в меню чата и выберем модель «Llama-3.2-3B-Instrcut», чтобы начать её использовать.

Введите свой промпт или пример в окне чата и нажмите Enter.

Подсказка: «Which sorting algorithm is the fastest and most popular? Please provide an example code»

(Какой алгоритм сортировки является самым быстрым и популярным? Пожалуйста, приведите пример кода)

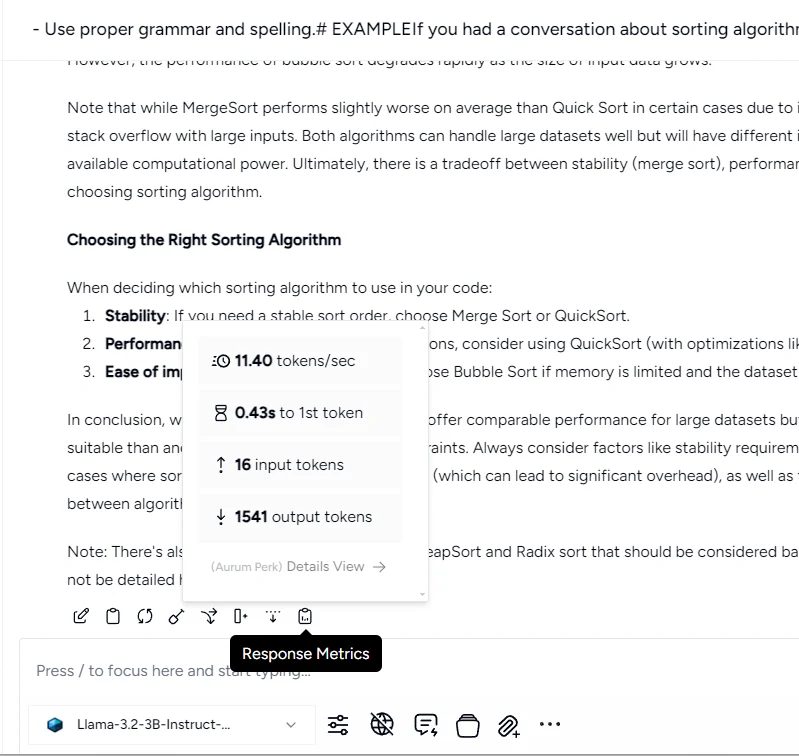

Результаты довольно точные, с подробными пояснениями. Я впечатлён. Я не ожидал такого от небольших моделей ИИ.

Ответ был быстрым, 11,40 токена в секунду. На моем ноутбуке в режиме работы CPU – отличный показатель

Использование визуальной модели Llama 3.2 с Groq API

Теперь мы получим доступ к модели зрения Llama 3.2 с помощью Groq API. В настоящее время для модели зрения нет файла GGUF, поэтому нам придётся получить доступ к модели зрения с помощью удалённого поставщика моделей ИИ.

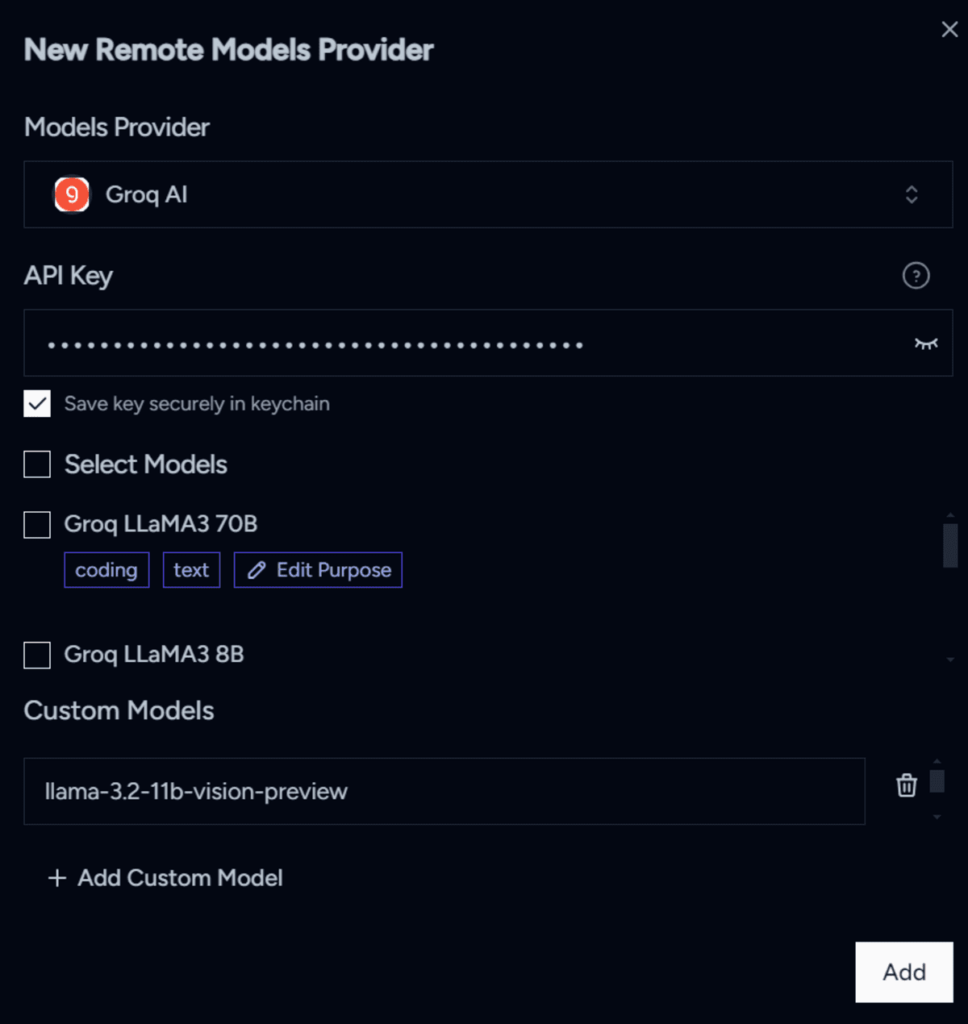

- Создайте учётную запись на GroqCloud и сгенерируйте ключ API.

- Перейдите в настройки Msty и нажмите на вкладку «Поставщики удалённых моделей», нажмите на кнопку «+ Добавить нового поставщика»

- Выберите поставщика моделей «Groq AI», затем вставьте ключ API и нажмите кнопку «+ Добавить пользовательскую модель». Затем введите название модели «llama-3.2-11b-vision-preview».

- Перейдите в меню чата и выберите модель Groq AI Llama 3.2.

- Добавьте изображение по своему выбору, а затем введите запрос в поле чата.

Подсказка: “Подробно объясните изображение”.

Модель Llama 3.2 довольно точно описывает изображение.

Вы можете попробовать все модели Groq AI, добавив их по отдельности с помощью кнопки «+ Добавить пользовательскую модель». Подробную информацию о моделях можно найти на GroqCloud.

Заключение

Использование настольных приложений-чатботов с открытым и закрытым исходным кодом с большими языковыми моделями локально стало довольно простым и доступным. Даже без подключения к интернету вы можете использовать эти модели для генерации кода, отладки кода или решения любых проблем.

В этом кратком руководстве мы узнали о настольном приложении Msty и о том, как использовать его для доступа к локальным и удалённым моделям Llama 3.2. Пожалуйста, сообщите мне в комментариях, если у вас возникнут какие-либо проблемы при работе с этими моделями.

Любезно взято: KDnuggets

Стоит попробовать поиграться с OpenChat 7B и DeepSeek Coder. Вроде как первая хорошо адекватно работает на русском