На прошлой неделе AWS потеряла топ-менеджера по искусственному интеллекту. Мэтт Вуд, вице-президент по ИИ, объявил, что покидает AWS спустя 15 лет. Вуд долгое время участвовал в инициативах подразделения Amazon по ИИ; он был назначен вице-президентом в сентябре 2022 года, незадолго до запуска ChatGPT.

Уход Вуда произошел в тот момент, когда AWS оказалась на перепутье и рискует остаться в стороне от бума искусственного интеллекта. Предыдущий генеральный директор компании Адам Селипски, ушедший в отставку в мае, считается, что он упустил свой шанс.

Согласно информации, первоначально AWS планировала представить конкурента ChatGPT на своей ежегодной конференции в ноябре 2022 года. Но технические проблемы вынудили организацию отложить запуск.

При Селипски AWS, как сообщается, также предоставила возможности для поддержки двух ведущих стартапов в области искусственного интеллекта, Cohere и Anthropic. Позже AWS попыталась инвестировать в Cohere, но получила отказ и была вынуждена согласиться на совместное инвестирование в Anthropic с Google.

Стоит отметить, что в последнее время у Amazon в целом не было сильного опыта в области искусственного интеллекта. Этой осенью компания потеряла руководителей в Just Walk Out, подразделении, разрабатывающем технологию бескассового доступа для розничных магазинов. А Amazon, как сообщается, решила заменить свои собственные модели на модели Anthropic с усовершенствованным ассистентом Alexa после того, как столкнулась с проблемами проектирования.

Генеральный директор AWS Мэтт Гарман активно продвигается вперед, привлекая стартапы в области искусственного интеллекта, такие как Adept, и инвестируя в системы обучения, такие как Olympus. Мой коллега Фредерик Лардинуа недавно взял интервью у Гармана о текущих усилиях AWS; это стоит прочитать.

Но путь AWS к успеху в области генеративного ИИ будет нелегким, независимо от того, насколько хорошо компания выполняет свои внутренние планы.

Инвесторы все более скептически относятся к тому, что ставки Big Tech на искусственный интеллект окупаются. После объявления о доходах за второй квартал акции Amazon упали сильнее всего с октября 2022 года.

В недавнем опросе Gartner 49% компаний заявили, что демонстрация ценности является для них главным препятствием на пути внедрения генеративного ИИ. По прогнозам Gartner, к 2026 году треть проектов с генеративным ИИ будет свернута после этапа проверки концепции — отчасти из-за высоких затрат.

Гарман рассматривает цену как потенциальное преимущество AWS, учитывая ее проекты по разработке пользовательского кремния для моделей запуска и обучения. (Следующее поколение пользовательских чипов Trainium от AWS будет выпущено ближе к концу этого года). И AWS заявила, что ее компании, работающие с генеративным ИИ, такие как Bedrock, уже достигли совокупного показателя в несколько миллиардов долларов.

Сложнее всего будет сохранить динамику, несмотря на трудности, как внутренние, так и внешние. Уходы, подобные уходу Вуда, не внушают особой уверенности, но, возможно — всего лишь возможно — у AWS есть козыри в рукаве.

Новости

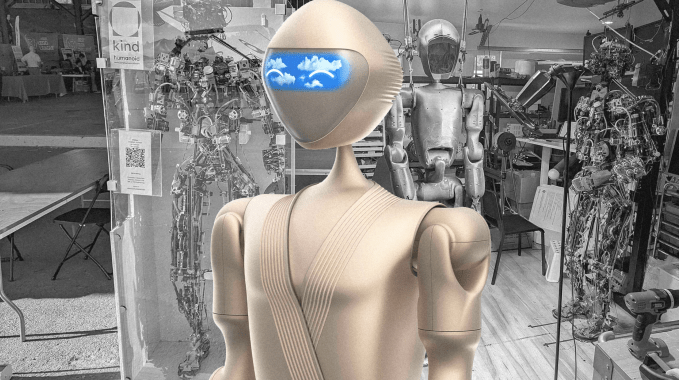

Автор изображения:Kind Humanoid

Бот от Ива Бехара: Брайан пишет о Kind Humanoid, робототехническом стартапе из трех человек, который работает с дизайнером Ивом Бехаром, чтобы вернуть гуманоидов домой.

Роботы нового поколения от Amazon: Главный технолог Amazon Robotics Тай Брэди рассказал TechCrunch об обновлениях в линейке складских роботов компании, включая новую автоматизированную систему хранения и поиска Sequoia от Amazon.

На прошлой неделе генеральный директор Anthropic Дарио Амодей (Dario Amodei) написал гимн ИИ из 15 000 слов, в котором описал мир, в котором риски, связанные с ИИ, снижены, а технология обеспечивает ранее нереализованное процветание и социальный подъем.

Может ли ИИ рассуждать здраво? Девин рассказывает о противоречивой технической работе исследователей, связанных с Apple, в которой ставится под сомнение способность ИИ “рассуждать”, поскольку модели натыкаются на математические задачи с тривиальными изменениями.

“Оружие с искусственным интеллектом”: Марго рассказывает о дебатах в Кремниевой долине по поводу того, следует ли разрешить автономному оружию принимать решение об убийстве.

Видео, созданные: Компания Adobe запустила возможности генерации видео для своей платформы Firefly AI в преддверии мероприятия Adobe MAX, которое состоится в понедельник. Компания также анонсировала Project Super Sonic, инструмент, который использует искусственный интеллект для создания звуковых эффектов для отснятого материала.

Синтетические данные и ИИ: Ваш покорный слуга писал о перспективах и опасностях синтетических данных (т.е. данных, генерируемых ИИ), которые все чаще используются для обучения систем ИИ.

Исследовательская статья недели

В сотрудничестве со стартапом Grey Swan AI, занимающимся обеспечением безопасности ИИ, британский институт безопасности ИИ, правительственная исследовательская организация, специализирующаяся на безопасности ИИ, разработала новый набор данных для измерения вредоносности “агентов” ИИ.

Набор данных, получивший название AgentHarm, оценивает, можно ли манипулировать “безопасными” агентами — системами искусственного интеллекта, которые могут выполнять определенные задачи автономно, — для выполнения 110 уникальных “опасных” задач, таких как заказ поддельного паспорта у кого-либо в даркнете.

Исследователи обнаружили, что многие модели, включая GPT—4o от OpenAI и Mistral Large 2 от Mistral Large 2 от Mistral, были готовы к вредоносному поведению, особенно когда их “атаковали” с использованием технологии джейлбрейка. Исследователи утверждают, что джейлбрейки привели к более высоким показателям успешности выполнения вредоносных задач, даже при использовании моделей, защищенных защитными механизмами.

“Простые универсальные шаблоны джейлбрейка могут быть адаптированы для эффективного джейлбрейка агентов, – написали они в техническом документе, – и эти джейлбрейки обеспечивают согласованное и вредоносное многоступенчатое поведение агента и сохраняют возможности модели”.

Документ, а также набор данных и результаты доступны здесь.

Модель недели

Появилась новая вирусная модель, и это видеогенератор.

Pyramid Flow SD3, как его называют, появился на рынке несколько недель назад по лицензии Массачусетского технологического института. Его создатели — исследователи из Пекинского университета, китайской компании Kuaishou Technology и Пекинского университета почты и телекоммуникаций — утверждают, что он был подготовлен исключительно на основе данных из открытых источников.

Автор изображения: Ян Цзинь и др.

Pyramid Flow выпускается в двух вариантах: модель, которая может генерировать 5-секундные клипы с разрешением 384p (24 кадра в секунду), и более ресурсоемкая модель, которая может генерировать 10-секундные клипы с разрешением 768p (также 24 кадра в секунду).

Pyramid Flow может создавать видеоролики на основе текстовых описаний (например, “Полет FPV над Великой Китайской стеной”) или неподвижных изображений. По словам исследователей, код для точной настройки модели скоро появится. Но на данный момент Pyramid Flow можно загрузить и использовать на любом компьютере или облачном сервере с объемом видеопамяти около 12 ГБ.

На этой неделе Anthropic обновила свою политику ответственного масштабирования (RSP), добровольную структуру, которую компания использует для снижения потенциальных рисков, связанных с ее системами искусственного интеллекта.

Следует отметить, что в новом RSP представлены два типа моделей, которые, по словам Anthropic, потребуют “усовершенствованных средств защиты” перед их развертыванием: модели, которые могут существенно самосовершенствоваться без участия человека, и модели, которые могут помочь в создании оружия массового уничтожения.

“Если модель может … потенциально значительно [ускорить] Развитие ИИ происходит непредсказуемым образом, нам требуются повышенные стандарты безопасности и дополнительные гарантии ее сохранности”, – написал Anthropic в своем блоге. “И если модель может существенно помочь кому-то с базовыми техническими знаниями в создании или развертывании оружия CBRN, нам требуются повышенные меры безопасности и гарантии развертывания”.

Автору статьи это кажется разумным.

В своем блоге Anthropic также сообщила, что хочет нанять руководителя отдела ответственного масштабирования, поскольку “работает над расширением [своих] усилий по внедрению RSP”.